할루시네이션

클로드3에서 최근에 여러 차례의 할루시네이션 현상을 겪었다. 한 달 전 사용할 때보다 뭔가 멍청해진 느낌도 들고.

AI에서 할루시네이션(환각, hallucination) 은 AI 모델이 학습 데이터에 없는 내용을 마치 사실인 것처럼 생성해내는 현상을 말한다. 대규모 언어 모델은 방대한 양의 텍스트 데이터로 학습되기 때문에 때로는 학습 과정에서 습득한 패턴과 지식을 조합해 실제로는 존재하지 않는 정보를 만들어 낼 수 있다. 즉, 사실이 아닌 내용을 사실처럼 말하거나 쓰게 되는 것.

마치 사람이 헛것을 보는 환각(hallucination) 현상과 유사하다고 해서 AI 할루시네이션이라고 부른다.

필자는 업무상 번역을 해야 하는 일이 있는데 보조적인 도움으로 클로드3를 활용하고 있다. 문장 구성이 상당히 매끄러워서 만족스럽게 사용 중인데 ‘가끔 없는 이야기’를 지어낼 때가 있다. 따라서 클로드3가 만들어낸 자료를 그대로 업무상이나 상업용으로 활용할 경우 ‘거짓말’이 포함될 수 있다는 이야기이다. 따라서 검증 과정이 필수적이다.

헛소리를 하는 것은 AI가 지닌 특성 중에 하나이며 이것이 인간이 AI 서비스에 팩트 체크를 의지하는 것은 매우 굉장히 위험하다는 말이다.

방언터진 클로드3

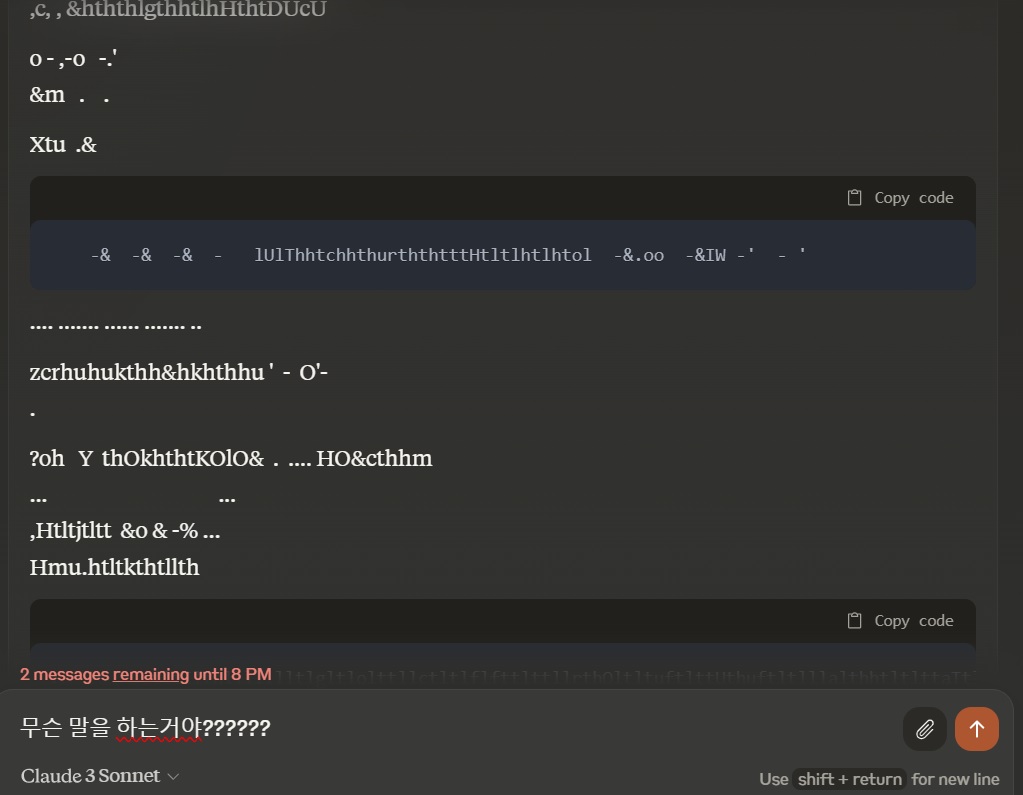

최근 겪은 클로드3의 환각 현상에서 방언을 목격했다. ㅋㅋㅋ

갑자기 외계어로 말을 하기 시작하는데 이런 것은 AI 혼자 습득하고 씨부리는건지 헷갈린다. 잘하면 AI만의 독자적인 외계어도 만들 수 있겠다는 생각이 든다.

방언터진 클로드3

(출처 : neonomadj.com)

말을 더듬기 시작한 클로드 3.

요새 너무 내가 많은 질문을 했나 싶을 정도로 황당한 답변. 이런 답변을 길게 그리고 오래할 때는 시간과 돈이 아까워진다.

말을 더듬는 클로드3

(출처 : neonomadj.com)

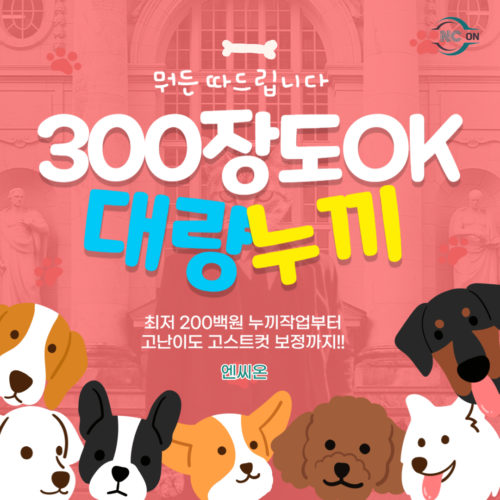

한 달에 3만원도 넘게 내고 유료로 사용 중인데 이거 한번 맛을 들였더니 편리함에 해지도 못하겠고, 키우는 강아지가 재롱 떠는 모습을 보는 느낌이랄까.

뭔가 귀엽기도 하고. 쩝.

최근 글(Recent Post / 最近的帖子)